-

大数据

大数据

Pre-A轮融资340万美元,大数据公司Taste Analytics通过挖掘用户吐槽内容智能化企业决策

大数据、云计算等技术在近几年得到迅猛的发展,但是在实际操作层面,中美之间还存在很大差距。国内的企业级客户在进行大数据分析时,仍以分析结构化数据为主,而在美国,很多企业已经开始分析非结构化数据,中国市场仍缺少这方面有效的分析工具。

据IDC的调查报告显示:企业中80%的数据都是非结构化数据,这些数据每年都按指数增长60%。

位于硅谷的Taste Analytics推出综合智能数据分析平台—— Signals,其最独特的地方在于既具备非结构化文本文档数据的深度分析能力,同时也支撑着各种传统的结构化数据 (报表、销售记录等)。

那么,什么是非结构化数据?

非结构化数据主要是指那些无法用固定结构来逻辑表达实现的数据,简单来说就是用户散落在论坛、微博、微信或其他渠道发表的关于产品的各种评价或吐槽。

从形态上,它主要包含这三大块:

第一是文本文字;

第二是图像、图片等;

第三是视频流、电视流。

对比一下或许更有助于理解,非结构化数据和结构化数据最本质的区别包括三个层面:

首先,非结构化数据的容量对比结构化数据要大,可以达到10几倍甚至几十倍的体量;

其次是产生的速度,比如Twitter刚出来的时候,每天产生一亿条的信息量,新浪微博的信息量更大,可以达到几十亿条信息;

最后是数据来源的多样性,这些数据来源有客服、邮件、调查问卷、社交网络等等。

因此,signals平台服务的对象不是企业的 IT、数据库,而是商业人员,例如市场营销,客服、信息洞察员、产品优化改进设计人员等。

以手机厂商为例,Signals通过对客户的邮件反馈、在论坛的相关讨论、微信、微博等相关评价信息分析,告诉设计师用户普遍反映电源键的位置设计很不人性化,手机开屏经常掉帧等等,从而进行产品优化。

非结构化数据既然这么复杂,那怎么分析?

Taste analytic主要是通过如下几个步骤进行非结构化数据分析的:

第一,数据采集,帮助企业更快更全的采集到各类数据。

signals集成了上百个数据接口,包括亚马逊、天猫、Salesforce,ZenDesk, Esty, Yelp、Twitter、Facebook、Apple Store、Google Play Store等,并且这个数字还在飞速扩大,根据taste analytic创始人汪晓宇的介绍,他们正在和国内的第三方数据提供商聚合数据、百分点等进行合作,将为中国客户提供更多本地化的数据。

非结构化数据接入口

第二,数据分析,也就是对于非结构化和结构化数据进行深度机器分析。

signal通过深度学习非结构化的自然语言,根据用户的用词、造句、行文方式来理解文字含义,通过对大范围的用户、上千万个消费点进行聚类分析。目前Signals平台具备成熟的实时分析包括中文在内的12种文字以及语音等非结构化数据的能力。

此外,Taste Analytics的服务适用于各种非结构化数据分析场景,只要有聊天记录、对话记录和邮件记录,就可以和数据源直接对接分析。

从各种维度进行分析

第三,将数据进行图像可视化。

Signals平台会把数据分析结果进行可视化输出,为客户提供10余种图像可视化模式,并且支持客户自定义分析,共包括15种不同的可视化分类。

将数据分析结果可视化

此外,汪晓宇告诉创业邦,Taste Analytics研发出的最先进的分析技术——预测性分析,也将在中国上线,用户可以享受到结构化和非结构数据的精准分析结果,系统针对关键词、时间趋势等因素对市场行为作出及时的预测。

依据上图的元素进行预测分析

那凭啥别人不能做或做不了?

与国内诸葛IO、GrowingIo不同的是,Taste Analytics主要针对的是文本非结构化的挖掘和处理,而诸葛IO是对于机器产生的数据流,Click数据的分析。对于企业来说,两者是相对互补的关系。

汪晓宇告诉创业邦,Taste Analytics成立两年,就已经获得了百万美元量级的订单,拥有像Ally银行、ForeSee问卷调查等客户,收入增长了6倍,并且季度营收增长速度保持在300%左右。

之所以取得这样的成绩,主要核心在于技术和人才,其技术壁垒在于文本数据的深度学习。

汪晓宇博士毕业于北京邮电大学的通信工程专业,之后就到美国直博,之后因为突出的学术贡献,被破格提拔为北卡大学夏洛特分校的助理敎授,并在美国五大视觉中心之一的夏洛特视觉中心任主任。他曾经应邀在美国海事国防安全风险大会演讲;还曾在斯坦福给计算机系的学生传授研发经验。

Taste Analytics的CTO俞立和Thomas Kraft,也是从美国顶级学府博士毕业,技术团队成员全都是硕士以上学历,博士占比达40%。

Taste Analytics在2月完成Pre-A轮340万美元融资,由真格基金领投,跟投机构包括聚合数据、华创资本等。

汪晓宇认为在实际操作中,图片、视频的潜力还大大没有被挖掘,机器数据和FinTech 瞬时高维度的金融数据也很有潜力。Taste Analytics未来将加大对图片和视频领域的非结构化数据分析。

来源:创业邦

-

大数据

大数据

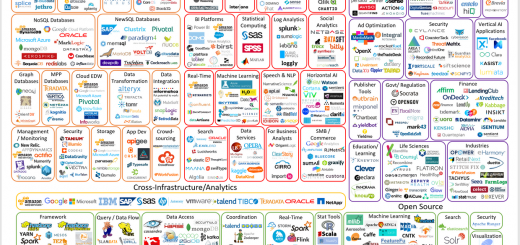

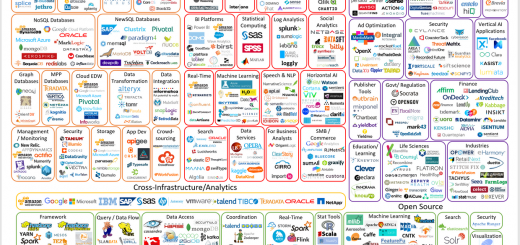

从大数据的风水图,来看到底大数据是怎么回事

本文中的Big Data Landscape图笔者随手分享在LinkedIn上,不晓得引起大量转发和评论,截止本周,得到6700个like,3800次share,400多条comment,笔者也觉得很神奇。这里就跟从事大数据或者投资领域的朋友推荐一下。原文作者是VC First Mark的Mark Turck,提下这一家VC,主要投资于早期阶段技术类公司的风险投资机构,包括新兴媒体、广告、游戏、教育、云计算、分析和基础设备等方向。大家熟悉的Airbnb,Pinterest,Shopify都有它的投资身影。

技术型的高科技创业公司都是喜欢闪闪发光的新东西,而“大数据”跟3年前火热程度相比反而有些凄惨。虽然Hadoop创建于2006年,在“大数据”的概念兴起到达白热化是在2011年至2014年期间,当时在媒体和行业面前,大数据就是“黑金石油”。但是现在有了某种高原感。 2015年数据世界中时尚年轻人喜欢转移到AI的相关概念,他们口味变成:机器智能,深度学习等。

除了不可避免的炒作周期,我们第四次年度“大数据风水图”(见下图),回顾过去一年发生的事情,思考这个行业的未来机会。

2016年大数据还是“回事”么?让我们深度挖掘。

企业级技术 = 艰苦的工作

其实大数据有趣的是它不是直接可以炒作的东西。

能够获得广泛兴趣的产品和服务往往是那些人们可以触摸和感受到的,比如:移动应用,社交网络,可穿戴设备,虚拟现实等。

但大数据,从根本上说是“管道”。当然,大数据支持许多消费者或企业用户体验,但其核心是企业的技术:数据库,分析等:而这后面几乎没人能看到东西运行。

而且如果大家真正工作过的都知道,在企业中改造新技术并不大可能在一夜之间发生。

早年的大数据是在大型互联网公司中(特别是谷歌,雅虎,Facebook,Twitter,LinkedIn等),它们重度使用和推动大数据技术。这些公司突然面临着前所未有的数据量,没有以前的基础设施,并能招到一些最好的工程师,所以他们基本上是从零开始搭建他们所需要的技术。开源的风气迅速蔓延,大量的新技术与更广阔的世界共享。随着时间推移,其中一些工程师离开了大型网络公司,开始自己的大数据初创公司。其他的“数字原生”的公司,其中包括许多独角兽,开始面临跟大型互联网公司同样需求,无论有没有基础设施,它们都是这些大数据技术的早期采用者。而早期的成功导致更多的创业和风险投资。

现在一晃几年了,我们现在是有大得多而棘手的机会:数据技术通过更广泛从中型企业到非常大的跨国公司。不同的是“数字原生”的公司,不必从头开始做。他们也有很多损失:在绝大多数的公司,现有的技术基础设施“够用”。这些组织也明白,宜早不宜迟需要进化,但他们不会一夜之间淘汰并更换关键任务的系统。任何发展都需要过程,预算,项目管理,导航,部门部署,全面的安全审计等。大型企业会小心谨慎地让年轻的创业公司处理他们的基础设施的关键部分。而且,一些(大多数?)企业家压根不想把他们的数据迁移到云中,至少不是公有云。

(大数据分析的基本流程图)

从另一个关键点大家就明白了:大数据的成功是不是实现一小片技术(如Hadoop的或其他任何东西),而是需要放在一起的技术,人员,流程的流水线。你需要采集数据,存储数据,清理数据,查询数据,分析数据,可视化数据。这将由产品来完成,有些由人力来完成。一切都需要无缝集成。归根结底,对于这一切工作,整个公司,从高级管理人员开始,需要致力于建立一个数据驱动的文化,大数据不是小事,而是全局的事。

换句话说:这是大量艰苦的工作。

部署阶段

以上解释了为什么几年后,虽然很多高调的创业公司上线也拿到引人注目的风险投资,但只是到达大数据部署和早期成熟阶段。

更有远见的大公司(称他们为“尝鲜者”在传统的技术采用周期),在2011 - 2013年开始早期实验大数据技术,推出Hadoop系统,或尝试单点解决方案。他们招聘了形形色色的人,可能工作头衔以前不存在(如“数据科学家”或“首席数据官”)。他们通过各种努力,包括在一个中央储存库或“数据湖”倾倒所有的数据,有时希望魔术随之而来(通常没有)。他们逐步建立内部竞争力,与不同厂商尝试,部署到线上,讨论在企业范围内实施推广。在许多情况下,他们不知道下一个重要的拐点在哪里,经过几年建设大数据基础架构,从他们公司业务用户的角度来看,也没有那么多东西去显示它。但很多吃力不讨好的工作已经完成,而部署在核心架构之上的应用程序又要开始做了。

下一组的大公司(称他们为“早期大众”在传统的技术采用周期)一直呆在场边,还在迷惑的望着这整个大数据这玩意。直到最近,他们希望大供应商(例如IBM)提供一个一站式的解决方案,但它们知道不会很快出现。他们看大数据全局图很恐怖,就真的想知道是否要跟那些经常发音相同,也就凑齐解决方案的创业公司一起做。他们试图弄清楚他们是否应该按顺序并逐步工作,首先构建基础设施,然后再分析应用层,或在同一时间做所有的,还是等到更容易做的东西出现。

生态系统正在走向成熟

同时,创业公司/供应商方面,大数据公司整体第一波(那些成立于2009年至2013)现在已经融资多轮,扩大他们的规模,积累了早期部署的成功与失败教训,也提供更成熟,久经考验的产品。现在有少数是上市公司(包括HortonWorks和New Relic 它们的IPO在2014年12月),而其他(Cloudera,MongoDB的,等等)都融了数亿美元。

VC投资仍然充满活力,2016年前几个星期看到一些巨额融资的晚期大数据初创公司:DataDog(9400万),BloomReach(5600万),Qubole(3000万), PlaceIQ( 2500万)这些大数据初创公司在2015年收到的$ 66.4亿创业投资,占高科技投资总额的11%。

随创业活动和资金的持续涌入,有些不错的资本退出,日益活跃的高科技巨头(亚马逊,谷歌和IBM),公司数量不断增加,这里就是2016年大数据全景图:

2016年2月12日修订,(本文最有价值的图)

很显然这里密密麻麻很多公司,从基本走势方面,动态的(创新,推出新的产品和公司)已逐渐从左向右移动,从基础设施层(开发人员/工程师)到分析层(数据科学家和分析师的世界)到应用层(商业用户和消费者),其中“大数据的本地应用程序”已经迅速崛起- 这是我们预计的格局。

大数据基础架构:创新仍然有很多

正是因为谷歌十年前的MapReduce和BigTable的论文,Doug Cutting, Mike Cafarella开发 创建Hadoop的,所以大数据的基础架构层成熟了,也解决了一些关键问题。

而基础设施领域的不断创新蓬勃发展还是通过大量的开源活动。

(Spark带着Hadoop飞)

2015年毫无疑问是Apache Spark最火的一年,这是一个开源框架,利用内存中做处理。这开始得到了不少争论,从我们发布了前一版本以来,Spark被各个对手采纳,从IBM到Cloudera都给它相当的支持。 Spark的意义在于它有效地解决了一些使用Hadoop很慢的关键问题:它的速度要快得多(基准测试表明:Spark比Hadoop的MapReduce的快10到100倍),更容易编写,并非常适用于机器学习。

其他令人兴奋的框架的不断涌现,并获得新的动力,如Flink,Ignite,Samza,Kudu等。一些思想领袖认为Mesos的出现(一个框架以“对你的数据中心编程就像是单一的资源池”),不需要完全的Hadoop。即使是在数据库的世界,这似乎已经看到了更多的新兴的玩家让市场持续,大量令人兴奋的事情正在发生,从图形数据库的成熟(Neo4j),此次推出的专业数据库(时间序列数据库InfluxDB),CockroachDB,(受到谷歌Spanner启发出现,号称提供二者最好的SQL和NoSQL),数据仓库演变(Snowflake)。

大数据分析:现在的AI

在过去几个月的大趋势上,大数据分析已经越来越注重人工智能(各种形式和接口),去帮助分析海量数据,得出预测的见解。

最近AI的复活就好比大数据生的一个孩子。深度学习(获取了最多的人工智能关注的领域)背后的算法大部分在几十年前,但直到他们可以应用于代价便宜而速度够快的大量数据来充分发挥其潜力(Yann LeCun, Facebook深度学习研究员主管)。 AI和大数据之间的关系是如此密切,一些业内专家现在认为,AI已经遗憾地“爱上了大数据”(Geometric Intelligence)。

反过来,AI现在正在帮助大数据实现承诺。AI /机器学习的分析重点变成大数据进化逻辑的下一步:现在我有这些数据,我该怎么从中提取哪些洞察?当然,这其中的数据科学家们 - 从一开始他们的作用就是实现机器学习和做出有意义的数据模型。但渐渐地机器智能正在通过获得数据去协助数据科学家。新兴产品可以提取数学公式(Context Relevant)或自动构建和建议数据的科学模式,有可能产生最好的结果(DataRobot)。新的AI公司提供自动完成复杂的实体的标识(MetaMind,Clarifai,Dextro),或者提供强大预测分析(HyperScience)。

由于无监督学习的产品传播和提升,我们有趣的想知道AI与数据科学家的关系如何演变 - 朋友还是敌人? AI是肯定不会在短期内很快取代数据科学家,而是希望看到数据科学家通常执行的简单任务日益自动化,最后生产率大幅提高。

通过一切手段,AI /机器学习不是大数据分析的唯一趋势。令人兴奋的趋势是大数据BI平台的成熟及其日益增强的实时能力(SiSense,Arcadia)

大数据应用:一个真正的加速度

由于一些核心基础架构难题都已解决,大数据的应用层迅速建立。

在企业内部,各种工具已经出现,以帮助企业用户操作核心功能。例如,大数据通过大量的内部和外部的数据,实时更新数据,可以帮助销售和市场营销弄清楚哪些客户最有可能购买。客户服务应用可以帮助个性化服务; HR应用程序可帮助找出如何吸引和留住最优秀的员工;等

专业大数据应用已经在几乎任何垂直领域都很出色,从医疗保健(特别是在基因组学和药物研究),到财经到时尚到司法(Mark43)。

两个趋势值得关注。

首先,很多这些应用都是“大数据同乡”,因为他们本身就是建立在最新的大数据技术,并代表客户能够充分利用大数据的有效方式,无需部署底层的大数据技术,因为这些已“在一个盒子“,至少是对于那些特定功能 - 例如,ActionIQ是建立在Spark上,因此它的客户可以充分利用他们的营销部门Spark的权力,而无需实际部署Spark自己 - 在这种情况下,没有“流水线”。

第二,人工智能同样在应用程序级别有强大吸引力。例如,在猫捉老鼠的游戏,安全上,AI被广泛利用,它可以识别黑客和打击网络攻击。 “人工智能”对冲基金也开始出现。全部由AI驱动数字助理行业已经去年出现,从自动安排会议(x.ai)任务,到购物为您带来一切。这些解决方案依赖人工智能的程度差别很大,从接近100%的自动化,到个人的能力被AI增强 - 但是,趋势是明确的。

结论

在许多方面,我们仍处于大数据的早期。尽管它发展了几年,建设存储和数据的过程只是第一阶段的基础设施。 AI /机器学习出现在大数据的应用层的趋势。大数据和AI的结合将推动几乎每一个行业的创新,这令人难以置信。从这个角度来看,大数据机会甚至可能比人们认为的还大。

随着大数据的不断成熟,这个词本身可能会消失或者变得过时,没有人会使用它了。它是成功通过技术,变得很普遍,无处不在,并最终无形化。

原文:Is Big Data Still a Thing? (The 2016 Big Data Landscape)

如果大家继续对大数据感兴趣,可以参考本人的后Hadoop时代的大数据架构 - 董老师在硅谷 - 知乎专栏

------------------

关注如下微信公众号“董老师在硅谷”(donglaoshi-123),关注硅谷趋势,一起学习成长。

HRTechChina提供、关注最尖端的人力资源科技资讯。您可以搜索“HRTechChina”公众号或扫描以下二维码关注我们!

-

大数据

大数据

超越咨询顾问的算力,在 BI:大数据改变管理咨询

文章来源于知乎专栏:数据冰山,同时欢迎关注微信公众号:数据冰山

消费品企业应该如何使用内部产生以及外部采集的数据,像互联网公司一样建立用户画像与会员体系,以数据驱动的方式进行精细化的生产、运营和销售?

传统的管理咨询公司,虽然有无数顶尖的大脑,但是他们的大脑只靠 Excel 等简单工具的辅助,这样的算力,能不能满足上述的需求?

在 2015年 上半年,数据冰山团队有幸为国内一家时尚消费品行业的龙头公司进行数据平台的建设,历时半年,完成了内部数据的打通和洞察,用户画像,会员体系的搭建,以及外部数据获取与跟踪。在这里和大家分享我们的一些体会,希望更多的消费品企业可以用数据驱动的方式来进行精细化的运作。

其实作为龙头消费品企业,其数据生产能力与中等规模的互联网公司不相上下,支撑日常业务的 IT 系统大大小小共有十余个,比如:

1)分销系统:支撑全国上千家线下门店每日的销售配货,每日订单量在数十万量级;

2)电商订单系统:负责处理十余个主流电商(京东,天猫,唯品会,一号店,聚美,亚马逊,当当网,有赞等)的订单管理与客服;

3)仓库管理系统:负责全国各大区域的仓储物流,数千个 SKU 的备货情况;

4)BI 系统:负责各主要业务系统的数据聚合,制成日常统计报表;外加大大小小的财务系统,人力系统,绩效系统,品牌 / 分公司订货系统等,每日产生的数据维度以及量级其实已经相当庞大。

但和互联网公司相比,消费品企业的数据消费,数据分析能力存在明显的短板。越来越多的管理层也十分希望像互联网公司一样管理用户和数据,使用数据驱动他们的决策。

面对这样庞杂而分散的数据以及对快速实时产生数据的渴求,不仅传统企业的 IT 及经营分析部门束手无策,再高端的管理咨询公司也只能挠挠头说 “臣妾做不到呀”,实在是超越了这群聪明人大脑的算力。

接下来会从三个角度分享如何为传统行业搭建数据平台,首先介绍大数据(数据科学)与商业智能(BI)在消费品领域的应用,然后详细讲解用户画像与用户体系搭建,最后分享如何利用外部数据(电商,社交媒体)对行业趋势与其他企业的运营进行监控。

在这里面所用到的数据相关的技术,已经大大超越管理咨询顾问的算力。如同封面图中的《魔戒》水晶球 Palantiri,它如同数据技术赋予了人类及精灵看到任何地方的能力。而传统的人类,无论如何提高人肉的眼力,也只能到目力所及的有限范围。

1大数据和商业智能(BI)

我们很少说自己是一家大数据公司,因为大数据这三个字的意义更多是指一种概念和思维方式,并没有什么具体的含义,既不是一种工作也不是一种技术,可能勉强算得上是一些门槛稍高的,和数据科学有关的算法,技术以及工具的统一称谓,比如数据挖掘 (聚类,关联),机器学习 (逻辑回归,神经网络),比如自然语言处理,比如分布式运算 (Hadoop, Spark)。但在服务具体企业的时候,我们难免会被套上大数据的壳子,毕竟大家都在找能做 “大数据” 的公司。

相比大数据,Business Inteligence (BI) 的历史就要久远许多,在各大软件厂商的不断教育下,大中型公司几乎都采购了 BI 软件。其实 BI 也是一个比较宽泛的概念,和大数据一样包含了许许多多的技术和工具,像是数据仓库,OLAP cubes,Data Mart,Star schema,数据挖掘等等。那么他们究竟是不是同一个东西呢?

1.1商业智能(BI)

其实软件厂商所提供的 BI 软件与广义的 BI 概念还是有很大程度的区别。

为了追求高度的抽象化与通用性,BI 软件大部分时间所承担的责任是一家公司的各类报表应用:将各个 IT 系统的数据聚合至 BI,然后进行统计汇总,并统一在前端通过 BI portal 呈现出图表与数值,便于业务人员了解日常数据和运营情况。

所以除了 ETL 部分以外,BI 软件绝大多数的功能都是通用性极强的,跨行业,非定制化。ETL,是英文 Extract-Transform-Load 的缩写,用来描述将数据从来源端经过抽取(extract)、转换(transform)、加载(load)至目的端的过程。其实传统的消费品企业面对零散的数据库,特别需要 ETL 的服务。

ETL 看似低端,其实当今的大数据顶尖企业 Palantir,在最初为 CIA 服务的时候,也是从 ETL 开始的,让美帝特工不用在分散的多个数据库上分别做一次查询。

这也就决定了 BI 软件的 sweet spot 在于监控和绘制通用性的统计报表,比如时间序列统计,分布统计,分段统计等等。

图 1 展示了这家消费品企业两年间平均价格变动与总销量的时间序列,可以看出销量两年来稳步增长,有小周期性(一二月份卖得少,换季的月份卖得多),而卖出商品的价格两年保持基本一致,并呈明显周期性变化(对于时尚消费品,冬款的造价自然要高出夏款许多)。

图 2 展示了集团旗下各品牌的销量分布和占比,可见此集团有一个相当强悍的主品牌,以及 2-3 个在垂直领域表现不菲的子品牌,定期输出销量分布,可以监控各品牌的发展情况并衡量品牌策略是否成功。

BI 软件的强项是将这些业务数据汇总起来,无需编程即可绘制出可供长期监控的可视化报表,同时实现随时更新,而不是传统管理咨询的一份静态报告。传统咨询提供的报告,往往在出炉的第一天就过时了。

1.2数据科学

反观数据科学,如果站在一个数据工程师的立场上,BI 软件做的事情其实也属于数据分析的范畴,任何数据洞察,数据挖掘工作都需要涉及到这些通用维度的基本统计。但在这种浅层分析的基础之上,数据科学家可以通过带入较强的人为干预和行业性输入,做到许多高于 BI 的数据洞察。而将这些洞察落地,运用至具体产品设计,营销方案,会员体系和售后服务中,便可以像互联网公司一样,实现以数据驱动业务。

举一个实际的例子,图 3 是用户重复购买间隔的 CDF 曲线 (Cumulative distribution function)。横坐标代表天数,纵坐标代表百分比。数据显示,有 37%的用户在第一次购买后的一个月(30 天) 内会进行第二次购买,而 45%的用户在第二次购买后的一个月内进行了第三次购买,51%的用户在第三次购买后的一个月内进行了第四次购买。随着购买次数的增加,CDF 曲线向左倾斜,也就意味着用户在建立了品牌认知后,购买频率显著增高,两次购买之间的间隔明显缩短。

因此,诱发新用户建立品牌意识,进行二次购买的窗口为 3-4 个月的换季档,而对老客户的消费唤醒窗口期则更短,以 1-2 个月为最优。这是一个很典型的数据工程师利用自己的行业知识和经验来实现数据洞察的例子,也是 BI 软件无法做到的。首先研究复购间隔是消费品行业独有的场景,更重要的是想要完成这个洞察,其中所涉及的统计工作具有很强的定制性,也较为复杂,需要编写统计脚本或是使用多条复合 SQL 来实现,数据工程师的价值也在此有了体现。

除了复杂和高定制性的统计逻辑外,对于非结构化数据的处理和挖掘也并非 BI 软件的强项。对于大型消费品公司来说,全电商渠道的运营已经成了常态,每日来自京东,天猫,唯品会,一号店,聚美这些大型电商平台的订单数高达数万个。而这些订单中的邮寄地址里包含了巨大的信息量,比如用户所在的城市,地理位置,甚至是身份,职业,消费能力等等。通过程序和地图 API 将这些邮寄地址转化为经纬度后,可以对用户群做大量的精细研究。

图 4 便是我们利用送货地址做的用户群分布的热力图,以北京的海淀区为例,大量的用户密集集中在中关村周边,其次便是各大高校宿舍聚集的区域,如五道口,知春路等地。红色标签为品牌线下店铺位置,可见门店已经覆盖了中关村,北京大学和五道口等地,但对于知春路片区,以及用户相对集中的牡丹园并未开设分店。相比之下安贞里分店四周并没有特别多的目标用户群出没。于是有了图 4 的用户分布及店铺选址。

热力图这样的算力往往超过了管理咨询公司的能力范围,然而对于用户的选址却是很有价值。

对于一些并无日常监控必要的统计,有时也会贡献许多有价值的洞察。

图 5 展示了线上用户购买时间的分布情况。可以看得出,周末线上购物的时间十分均匀,除了半夜之外大部分时间段都有网购发生。相比之下工作日的线上购物时间分布就变得十分有趣,大量的订单集中产生在早上九点和十点之间,也就是说大量的时尚白领在上班途中,或是步入办公室后的第一件事便是败一件自己心仪的宝贝,然后才能心情舒畅地开始一天的工作。

那么不管是自营电商促销,短信推广,还是各宣传阵地的推送,工作日早上 8 点至 10 点都是一个不错的窗口。

和图 5 类似,图 6 将线上用户的购买数据按照一周七天进行分布统计,也会出现一些有意思的现象,比如周六周日上网买东西的用户极少,每周网购的出现在周一和周二。或许上班族们都是通过线上血拼来抚慰自己,治愈周一综合征的。而越临近周末,大家在线买东西的热情也就越低。

像图 5,图 6 这样的数据洞察往往也是 BI 软件无法捕捉到的。数据工程师们可以将这些没有长期监控的意义的指标转化成拥有商业价值的洞察。同时这又是传统的管理咨询公司无法做到的,因为他们缺乏能力整合如此海量的数据并按天甚至按小时进行实时输出。

个人认为,数据科学 (大数据) 和广义的商业智能原本没有本质区别,两者都涵盖了非常广泛的内容,并且两者的核心都是通过数据处理和分析的方式,提升业务表现。

但我们平时所谈论的 “BI” 很多时候其实指是软件厂商所提供的 BI 软件 / 套件,用于实现业务报表和统计监控的功能。暂且不提厂商们是否有故意偷换概念的嫌疑,BI 软件和数据科学还是有着比较大的差异。可以说 BI 软件通过高度抽象的方法,提供了一种非常便利的数据汇总,统计,可视化的工具,从而完成了数据科学的一部分工作,而许多深层次的,带有行业性的,高于 BI 软件的分析与洞察,仍然需要数据工程师的参与,以及特定数据系统的支撑来共同完成。

总结

与传统的管理咨询公司相比,在 BI 层面,大数据的相关技术胜在算力:数据整合能力、实时处理能力以及呈现能力。

这一期只是小小的开胃菜,而在后续的章节(关于建立用户画像和利用外部数据理解行业及趋势),大数据的相关技术将进一步将算力的差距拉得更大,让传统的脑力无法追赶。

-

大数据

大数据

大数据公司 Palantir 收购 Kimono Labs

Kimono Labs 被 Palantir 收购,并将于 2016年2月29日 停止服务。

Kimono Labs 由 Pratap Ranade 和 Ryan Rowe 联合创办,是在 Winter 2014 Y Combinator 项目中孵化的一家初创公司,其主要目的是把网站变成 API。

36 氪曾报道,互联网上的网站成千上万,里面蕴含着浩大的有用信息,但是绝大部分都是非结构化的,但要想利用这些信息,往往需要开发者进行辛苦的处理。Kimono 就是帮助开发者利用海量非结构化信息,可以在数秒内把非结构化的网站变成结构化的 API。其服务不需要编写代码,不用安装软件,只需把 Kimono 书签工具(bookmarklet)添加到浏览器即可。

接下来,开发者只需去到希望转换数据的网站,点击书签工具,然后选择想要的数据,剩下的事情交给 Kimono 即可将网站变成开发用的 API。Kimono 其中一位创始人甚至说自己的妈妈都能用来开发出一款查看太浩湖是否适合滑雪的应用。

这种便利的功能受到了开发者的热烈欢迎。据悉,推出刚刚 10 周,注册的开发者就达到了 2 万,且以每周 +15%的速度在增长。目前有超过 125000 名开发者、数据科学家和企业都在使用该项服务。

而硅谷大数据公司 Palantir,36 氪此前也报道过,逻辑就是收集大量数据,帮助非科技用户发现关键联系,并最终找到复杂问题的答案。该产品源自 PayPal,最初用做反欺诈措施。现在,美国情报机构如 CIA、FBI、DIA (国防情报局)、海陆空三军,以及警局等等都是它的客户。

收购前,Kimono Labs 从 Y Combinator、 CrunchFund、High Line Venture Partners、Cowboy Ventures、 Founders Fund 和众多天使投资者手中筹集到了 500 万美元的资金。收购后,Kimono Labs 宣布公司将安全清除所有的用户数据,包括姓名、邮箱地址、密码和服务器上的接口。公司保证 Palantir 不会获取这些数据。

据悉,目前用户仍可以从 Kimono Labs 的网页上检索数据, 3月31日 之前,还可以享受为期 30 天的端口服务。

本文编译自:venturebeat.com,如若转载,请注明出处:https://36kr.com/p/5043381.html

-

大数据

大数据

500 Miles:用大数据,帮你找到最合适的职业

来源:猎云网 (编译:马小白)

对于很多年轻的工作人士来说,在合适的公司找到一份适合自己的工作也许不是件容易事。他们可能在接受了工作之后才发现这份工作并不适合自己,或者他们无法在这片领域做出巨大成就。这种情况的出现主要是因为求职者没有获得全面有效的信息。

一家叫做500 Miles的创业公司开发了一种数据驱动平台,声称可以将你直接匹配到公司空缺的职务上,在这里你可以变得大受欢迎。

如今,这家公司已经推出了自己的在iOS和Android手机客户端的应用。

由Viral Kadakia和Murali Sangubhatla一起创办的500 Miles起初听起来和美国巨兽公司(Monster.com)或者其他的传统的求职平台很相似,但他们之间特别是在对数据的利用上还是有一些不同之处的。500 Miles从你的个人简介中获取有用信息,比如你期望的职位类别,工作许可状态,偏爱的工作地点,念过的学校,和过去的雇主……然后给你最人性化的职位推荐。你可以用注册的用户名和密码登陆,也可以通过Facebook登录,但不能通过LinkedIn登录。

除了提供与你要求相符合的职位外,500 Miles还针对你感兴趣的公司提供一种“公正评价”式的服务。通过这项功能你所获得的数据不只是一些来自Glassdoor,Kadakia和VentureBeat这些职业点评网站上就能搜到的传闻。相反,该功能通过收集网页上的各种各样的可利用的资源来编制一家公司的简介。

这样你不仅会对这家公司有更好的认知,而且还可以了解到你和这家公司之间千丝万缕的联系,比如你的前同事或者你的校友在那里工作。

除了这些对公司的独特见解和个性化的推荐方案外,500 Miles还有一个特点是具备搜索功能,可以让你搜索公司名称,特定地点等等。不仅如此,该功能还设有堆栈应用,所谓堆栈是指基于某一些相似属性而将一系列的公司组合到一起,比如“在金融科技领域快速发展的公司”,“女性雇员数量最多的科技公司”。

Kadakia将500 Miles描述成“一套从发现到评估全承包的解决方案。”

一旦发现了你喜欢的职位,你可以直接和公司接触或者通过500 Miles的手机应用与公司取得联系,只要这些公司在500 Miles设置了招聘职位。考虑到实际需要,500 Miles的这套申请系统可以让申请者为简历直接拍摄照片并立即上传。Kadakia说这项服务可以为用户提供实时更新,你会知道面试官何时打开你的简历、何时在阅读它以及最后是否被录用。求职者自己也可以浏览自己之前的职位申请。

目前为止已经有超过1000家公司使用了这套系统中的评价功能,和7家签约的合作伙伴,他们利用500 Miles这个平台发布招聘职位并接受求职者申请。Kadakia说,实际上签约的雇主是“成群结队,”像Zenefits、Ignite这样的公司或者其他的参与者们都渴望能提升自己的品牌效应并招揽顶尖的人才。而通过为500 Miles提供支持,雇佣公司们可以提前获得任何关于自己的负面评价,同时对系统积极的评价进行支持。

表面上看来,500 Miles势头强劲,但是在如今的市场上,它很有可能遭到来自LinkedIn,Hired或者其他职位搜索引擎的竞争,他们当中的很多也可以为用户个性化的职位推荐。

在2015年7月首次推出测试版后,现在已经有超过1000位来自美国各个州的用户希望通过500 Miles找到工作。

正如Kadakia自己描述的那样,他的用户们“寻找的企业不用大,只要能与公司一同成长并且不断学习把自己变到最好。”

Source:VB

-

大数据

大数据

2016大数据版图

编者注:原文是 FirstMark Capital 的 Matt Turck 的文章。本文全面总结了大数据领域的发展态势,分析认为尽管大数据作为一个术语似乎已经过气,但是大数据分析与应用才刚刚开始兴起,在与 AI、人工智能等新兴技术的结合下,大数据的机会也许要比大家想象的还要大。

在喜新厌旧的技术初创企业界,已有 3年 历史 “大数据” 听起来似乎已经过气了。虽然 Hadoop 在 2006年 已经出来,但 “大数据” 这个概念大概是在 2011 到 2014年 左右才真正火起来的。也就是在这段时间里,至少是在媒体或者专家眼里,“大数据” 成为了新的 “金子” 或者 “石油”。然而,至少在我跟业界人士交谈中,大家越来越感觉到这项技术已经在某种程度上陷入了停滞。2015年 可能是数据领域的那些酷小子转移兴趣,开始沉迷于 AI 以及机器智能、深度学习等许多相关概念的年份。

抛开不可避免的炒作周期曲线态势不管,我们的 “大数据版图” 已经进入第 4 个年头了,趁这个时候退一步来反思一下去年发生了什么,思考一下这个行业的未来会怎样是很有意义的。

那么 2016年 大数据到底还算不算个 “东西” 呢?我们不妨探讨一下。

企业技术=艰苦工作

大数据有趣的一点在于,它不再像当初经历过那样有可能成为炒作的题材了。

经过炒作周期后仍能引起广泛兴趣的产品和服务往往那些大家能够接触、可以感知,或者与大众相关联的:比如移动应用、社交网络、可穿戴、虚拟现实等。

但大数据基本上就是管道设施的一种。当然,大数据为许多消费者或商业用户体验提供了动力,但它的核心是企业技术:数据库、分析等,这些东西都是在后端运行的,没几个人能看得见。就像在那个世界工作的任何人都知道那样,用一个晚上的时间就想适应企业端的新技术是不可能的。

大数据现象在早期主要是受到了与一批骨干互联网公司(尤其是 Google、Facebook、Twitter 等)的共生关系的推动,这些公司既是核心大数据技术的重度用户,同时也是这些技术的创造者。这些公司突然间面对着规模前所未有的庞大数据时,由于本身缺乏传统的(昂贵的)基础设施,也没有办法招募到一些最好的工程师,所以只好自己动手来开发所需的技术。后来随着开源运动的迅速发展,一大批此类新技术开始共享到更广的范围。然后,一些互联网大公司的工程师离职去创办自己的大数据初创企业。其他的一些 “数字原生” 公司,包括崭露头角的独角兽公司,也开始面临着互联网大公司的类似需求,由于它们自身也没有传统的基础设施,所以自然就成为了那些大数据技术的早期采用者。而早期的成功又导致了更多的创业活动发生,并获得了更多的 VC 资助,从而带动了大数据的起势。

快速发展了几年之后,现在我们面临的是更加广阔、但也更加棘手的机遇:让中等规模到跨国公司级别的更大一批企业采用大数据技术。这些公司跟 “数字原生” 公司不一样的是,他们没有从零开始的有利条件。而且他们失去的会更多:这些公司绝大部分的现有技术基础设施都是成功的。那些基础设施当然未必是功能完备的,组织内部许多人也意识到对自己的遗留基础设施进行现代化应该是早点好过晚点,但他们不会一夜间就把自己的关键业务取代掉。任何革命都需要过程、预算、项目管理、试点、局部部署以及完备的安全审计等。大企业对由年轻的初创企业来处理自己基础设施的关键部分的谨慎是可以理解的。还有,令创业者感到绝望的是,许多(还是大多数?)企业仍顽固地拒绝把数据迁移到云端(至少不愿迁移到公有云)。

还需要理解的另一个关键是:大数据的成功不在于实现技术的某一方面(像 Hadoop 什么的),而是需要把一连串的技术、人和流程糅合到一起。你得捕捉数据、存储数据、清洗数据、查询数据、分析数据并对数据进行可视化。这些工作一部分可以由产品来完成,而有的则需要人来做。一切都需要无缝集成起来。最后,要想让所有这一切发挥作用,整个公司从上到下都需要树立以数据驱动的文化,这样大数据才不仅仅是个 “东西”,而且就是那个(关键的)“东西”。

换句话说:有一堆艰苦的工作要做。

部署阶段

所以,这就是在经过几年引人瞩目的初创企业如雨后春笋冒头,VC 投资频等头条后,我们开始步入大数据的部署期和早期成熟期的原因。

更有前瞻性的大公司(姑且称之为传统技术采用周期的 “早期采用者”)在 2011 到 2013年 间开始实验大数据技术,推出了若干的 Hadoop 试点计划(往往是因为赶时髦)或者尝试一些点方案。他们招募了各种各样此前并不存在的岗位(如 “数据科学家” 或 “首席数据官”)。他们进行了各种努力,包括吧全部数据都堆到一个数据容器(“data lake”),然后希望紧跟着就会发生奇迹(往往不会)。他们逐步建设自己的内部能力,试验了各种供应商,从试点计划到生产中的局部部署,然后到现在争论要不要全企业铺开(全范围铺开实施的情况还很罕见)。许多情况下,他们正处在这样一个重要的拐点上,即经过大数据基础设施的数年建设后,能够展示的成果还不多,至少在公司内部的商业用户看来是这样的。但是大量吃力不讨好的工作已经做完了,现在开始进入到有影响力的应用部署阶段了。只是从目前来看,这种建构在核心架构之上的应用数量还不成比例。

接下来的一波大公司(称之为传统技术采用周期的 “早期多数使用者”)大多数时候对大数据技术是持观望态度的,对于整个大数据方面的东西,他们还在心存一定程度困惑中观望。直到最近,他们还在指望某个大型供应商(比如 IBM)会提供一个一站式的解决方案,不过现在看来这种情况近期内并不会出现。他们看待这个大数据版图的态度是心怀恐惧,在想自己是不是真的需要跟这一堆看起来并没有什么不同的初创企业合作,然后修补出各种解决方案。

生态体系正在成熟

与此同时,在初创企业 / 供应商这一块,整个第一波的大数据公司(2009 至 2013年 间成立的那批)现在已经融了数轮的资金,企业规模已经得到了扩大,并且从早期部署的成功或失败中学到了东西,现在他们已经能够提供更成熟的、经受过考验的产品了。少数一些已经成为了上市公司(包括 2015年 上市的 HortonWorks 和 New Relic),而有的(比如 Cloudera、MongoDB 等)融资已经达上亿美元了。

这个领域的 VC 融资活动仍然很有生气,2016年 的前几周我们见证好几轮相当可观的后期阶段大数据融资事件:DataDog(9400 万美元),BloomReach(5600 万美元),Qubole(3000 万美元),PlaceIQ(2500 万美元)等。2015年 大数据初创企业拿到的融资额达到了 66.4 亿美元,占整个技术 VC 总融资额额 11%。

并购活动则开展得中规中矩(自从上一版大数据版图发布以来完成了 34 项并购,具体可参见附注)

随着该领域的创业活动持续进行以及资金的不断流入,加上适度的少量退出,以及越来越活跃的技术巨头(尤其是 Amazon、Google、IBM),使得这个领域的公司日益增多,最后汇成了这幅 2016 版的大数据版图。

显然这张图已经很挤了,而且还有很多都没办法列进去(关于我们的方法论可以参见附注)

在基本趋势方面,行动开始慢慢从左转到右(即创新、推出新产品和新公司),从基础设施层(开发者 / 工程师的世界)转移到分析层(数据科学家和分析师的世界)乃至应用层(商业用户和消费者的世界),“大数据原生应用” 已经在迅速冒头—这多少符合了我们原先的一些预期。

大数据基础设施:仍有大量创新

Google 由 Cutting 和 MikeCafarella 主导的关于 MapReduce 和 BigTable 的论文(Hadoop 的基础)问世已有 10年 了,在这段时间里,大数据的基础设施层已经逐渐成熟,一些关键问题也得到了解决。

但是,基础设施领域的创新仍然富有活力,这很大程度上是得益于可观的开源活动规模。

2015年 无疑是 Apache Spark 之年。自我们发布上一版大数据版图以来,这个利用了内存处理的开源框架就开始引发众多讨论。自那以后,Spark 受到了从 IBM 到 Cloudera 的各式玩家的拥护,让它获得了可观的信任度。Spark 的出现是很有意义的,因为它解决了一些导致 Hadoop 采用放缓的关键问题:Spark 速度变快了很多(基准测试表明 Spark 比 Hadoop 的 MapReduce 快 10 到 100 倍),更容易编程,并且跟机器学习能够很好地搭配。

除了 Spark 以外,还出现了其他的一些令人兴奋的框架,比如 Flink、Ignite、Samza、Kudu 等,这些框架的发展势头也很好。一些思想领袖认为,Mesos(数据中心资源管理系统,把数据中心当作一台大计算资源池进行编程)的出现也刺激了对 Hadoop 的需求。

即便在数据库的世界里,新兴的玩家似乎也越来越多。多到市场已经难以承受的地步,这里发生了很多令人兴奋的事情,从图形数据库(如 Neo4j )的成熟,到专门数据库的推出(如统计时序数据库 InfluxDB),乃至于 CockroachDB 的出现(受 Google Spanner 灵感启发诞生的融合了 SQL 与 NoSQL 长处的新型数据库)。数据仓库也在演变(如云数据仓库 Snowflake)。

大数据分析:现在跟 AI 结合了

大数据分析过去几个月出现的一股趋势是,越来越关注利用人工智能(形式和风格各异)来帮助分析大规模的数据,从而获得预测性的洞察。

其实最近出现复兴的 AI 很大程度上算是大数据的产物。深度学习(最近受到关注最多的 AI 领域)背后的算法基本上是几十年前就诞生了的,但直到最近能够以足够便宜、足够快速地应用到大规模数据之后才发挥出了它的最大潜能。AI 与大数据之间的关系如此紧密,以至于业界专家现在认为 AI 已经令人懊恼地 “与大数据陷入了热恋当中”。

不过反过来,AI 现在也在帮助大数据实现后者的承诺。分析对 AI/ 机器学习越来越多的关注也符合大数据下一步演进的趋势:现在数据我都有了,但究竟从中能得到什么样的洞察呢?当然,这件事情可以让数据科学家来解决,从一开始他们的角色就是实现机器学习,否则的话就得想出模型来发现数据的意义。但是机器智能现在正在逐渐发挥辅助数据科学家的作用—只需要倒腾数据,新兴的产品就能从中提炼出数学公式(如 Context Relevant)或者自动建立和推荐最有可能返回最佳结果的数据科学模型(如 DataRobot)。一批新的 AI 公司提供的产品能够自动识别像图像这样的复杂实体(如 Clarifai、Dextro),或者提供强大的预测性分析(如 HyperScience)。

同时,随着基于无监督学习的产品的传播和改善,看看它们与数据科学家之间的关系如何演变将非常有趣—将来这两者是敌还是友呢?AI 当然不会很快取代数据科学家的位置,但预计会看到数据科学家通常执行的更简单一点的工作越来越多的自动化,从而可以极大提高生产力。

但不管怎样,AI/ 机器学习绝不是大数据分析唯一值得关注的趋势。大数据 BI 平台的普遍成熟及其日益增强的实时能力也是一个令人兴奋的趋势(如 SiSense、Arcadia Data 等)。

大数据应用:真正的加速

随着一些核心基础设施的挑战得到解决,大数据应用层正在快速构建。

在企业内部,已经出现了各种工具来帮助跨多个核心职能的企业用户。比方说,销售和营销的大数据应用通过处理大规模的内外部数据来帮助找出哪位客户可能会购买、续约或者流失,且速度越来越实时化。客服应用帮助个性化服务。人力应用帮助找出如何吸引和挽留最好的员工等。

专门的大数据应用几乎在任何一个垂直行业都有出现,从医疗保健(尤其是基因组学和药物研究)到金融、时尚乃至于执法(如 Mark43)。

有两个趋势值得强调一下。

首先,这些应用很多都是 “大数据原生” 的,本身都是依托在最新的大数据技术基础上开发的,代表了一种客户无须部署底层大数据技术即可利用大数据的有趣方式—因为那些底层技术已经是打包的,至少对于特定功能来说是这样的。比方说,ActionIQ 就是在 Spark 基础上开发的(或者说是 Spark 的一个派生),所以它的客户能够在营销部门利用 Spark 的威力而不需要自己部署 Spark,这种情况下是没有 “装配线” 的。

其次,AI 在应用层也有很强大的存在。比方说,在猫捉老鼠的安全领域中,AI 被广泛用来对付黑客,实时识别和对抗网络攻击。去年已经出现了一个 AI 驱动的数字助手行业,支持从任务自动化到会议安排(如 x.ai)以及购物等几乎一切事情。这些解决方案对 AI 的依赖程度不一,从几乎 100%自动化到 “有人参与” 等情况各不相同,但是可以明确的是,人的能力在 AI 帮助下得到了增强。

结论

从很多方面来看,我们仍然处在大数据现象的早期发展阶段。尽管已经花费了数年时间,但减少基础设施来存储和处理大规模数据还只是第一阶段。AI/ 机器学习已经成为大数据应用层的一股迅猛趋势。大数据与 AI 的结合将会推动很多行业的惊人创新。从这个角度来说,大数据的机会也许要比大家想象的还要大。

然而,随着大数据继续走向成熟,这个术语本身可能会消失,或者变得太过时以至于没有人会再使用这个词。这就是成功赋能技术令人讽刺的命运归宿—由于技术的广泛传播,然后到达无所不在的地步,最后被人熟视无睹。

附注:

1)由于不可能把大数据的所有公司都列到图表上,所以我们只能按照一定原则筛选部分公司出来,筛选原则一是进行过 1 轮或多轮 VC 融资的初创企业,二是把一些我们特别感兴趣的较早期初创企业列进去。

2)值得注意的收购包括 Revolution Analytics(微软 2015年1月 收购),Mortar(DataDog2015年2月 收购),Acunu 和 FoundationDB(2015年3月 被苹果收购),AlchemyAPI(2015年3月 被 IBM 收购),Amiato(2015年4月 被 Amazon 收购),Next Big Sound(2015年5月 被 Pandora 收购),1010Data(Advance/Newhouse 2015年8月 收购),Boundary(BMC 2015年8月 收购),Bime Analytics(Zendesk 2015年10月 收购),CleverSafe(IBM 2015年10月 收购),ParStream(2015年11月 被思科收购),Lex Machine(2015年11月 被 LexisNexis 收购),DataHero(2016年1月 被 Cloudability 收购)。

本文编译自:mattturck.com

-

大数据

大数据

从技术牛到创业狗,他不满安全行业现状,开发了一套可为企业武装到牙齿的自适应安全产品

随着云计算技术的迅猛发展,越来越多的企业选择把服务器搬到了云,而云计算必须建立在大数据基础之上,数据的价值就越来越重要。然而,事实上很多公司在数据安全方面还是很薄弱的,用行内话说,“挂个脚本就把你黑了”,就连苹果公司都免不了被黑。

“青藤主要为企业提供内部的自适应安全体系,让企业在自身内部搭建起安全管理体系,并可持续地运营,从而提高工作效率,节省成本”,青藤云创始人张福告诉创业邦。

为什么企业这么容易被黑?

既然企业安全人人都知道重要,但是为什么企业做不好呢?张福认为主要有如下4种原因:

企业安全意识较低,近年来随着安全事件的不断曝光才开始重视起来;

安全方面的人才匮乏,体制内教育跟不上市场发展速度;

安全人员缺乏有效的工具,一直处于“救火”状态,一边查问题根源,一边又有新的问题出现;

企业处于被动防守状态,只能从外部黑客攻击中寻找漏洞,设防火墙。

如今随着业务发展,内部生态复杂,对外交互越来越多,这就使得公司网站系统被攻破的通路增多了。再加上用户大数据价值的凸显,诱使外面的攻击火力不断升级。

“整个黑客的产业链要比安全产业链庞大数倍。”这是青藤云创始人张福对于中国安全行业的反讽。

让企业“武装到牙齿”

针对如上痛点,青藤云安全为企业提供从评估到监测再到防御的安全服务,主要分为如下三个方面:

第一、提供自适应安全Analysor(分析器),可理解为360病毒扫描软件。在公司系统内部部署点引擎之后,分析器会像普罗米修斯里的地形探测器一样对网站结构搜索并扫描探测隐患,给出安全分数。同时,分析器会进行持续地扫描,对网站数据进行环比、同比,和业务相同客户进行行业比较。

第二、提供自适应安全builder(产生器),帮企业补漏洞并防止再犯。公司如果设置了弱口令的漏洞可以自己修改弥补,青藤云安全则帮企业建立纠错机制,避免之前出现的问题。同时建立安全体系,缩小攻击面,控制风险。

第三,提供自适应安全monitor(检测器),紧急预警。在公司系统部署的监测点发现攻击时,立刻采取措施,系统自己解决不了的问题就会报警,请求人工解决。

这样一来,一方面为安全人员提供实践可操作的工具,提高效率,另一方面从公司内部主动建立起安全体系而不再被动防御。

青藤云安全系统工作机制

后置监测点,“引狼入室”,提高排查精准性

但是,机器的自适应是否会产生误判呢?张福告诉创业邦记者,误判的概率是存在的,但几乎接近于零。

黑客们常见的攻击方法是,为了使真正攻击不被发现先进行大规模扫描,系统便会频繁报警,安全人员找不到问题根源,在这之后黑客才开始真正开始攻击。

张福告诉创业邦记者,青藤云安全的监测点是相对后置的,黑客的大规模扫描并不会对系统产生任何影响,但当黑客真正开始深入到核心点,青藤便开始采取措施,甚至报警,减少安全人员排查的干扰,提高准确性。

此外,黑客攻击整个系统时,会先找一个外围的点,接近核心数据需要过程,在黑客深入的10秒内就能发现,并采取措施,所以不用担心后置会耽误防御时间。

自适应公司业务系统

青藤云安全的这套解决方案主要特征是自适应的技术,这种安全理念从2014年开始在美国兴起,核心是通过业务层面量身定做主动地防御系统。通俗地来说,就是为打车的滴滴、卖家电的苏宁和叫外卖的饿了么根据日常商业行为各自生成一套安全机制。张福告诉创业邦记者,这样的技术实现主要依赖于“数据分析+机器学习+人的经验”。

这样的安全机制主要有如下几个特点:

自适应基础架构,无论是公有云、私有云还是物理机,均可部署;

自适应公司业务,根据业务产生适配规则;

自适应系统变化,系统更新、搬迁后,监测自动跟进。

为企业建造安全免疫系统,而非防火墙

青藤相较于云盾、安全宝等传统防火墙的云形态产品的差异化优势主要在“青藤设计免疫系统,而不是造城墙”。

从产品形态上来看,云盾和安全宝主要是在外围造城墙进行防御。而青藤是为用户设计免疫系统,不仅防御外部攻击,而且内部发现和解决客户自身安全问题,同时能够随业务变化而变化。

青藤会根据客户公司的业务情况,自适应生成最符合客户业务的安全策略。不仅帮助客户加强网站的安全性,还可以进行完整的安全体系建设。

青藤创始人张福是国内最早一批黑客技术研究者,在安全攻防领域有超过15年的实践经验,曾先后在国内多家知名互联网企业如九城、51.com、盛大、昆仑万维担任技术和业务安全负责人,主导设计开发了九城游戏代码漏洞挖掘平台、51.com互动压力测试系统、盛大旁路式游戏反外挂系统等多款创新性产品,精通互联网业务研发和安全体系两个领域。

2015年12月,青藤云安全获得宽带资本、红点创投6000万人民币A轮融资。

来源:创业邦

-

大数据

大数据

搜索难用、个性推荐不准?达观数据以此切入大数据服务

几乎每见一个创业者,我都会听到一次 “…,然后我们用大数据做用户精准画像 / 智能推荐 / 金融征信…”,其中有多少人举着大数据的旗、干着基础数理统计的事,大家心知肚明。

大数据背后的技术算法是核心,创业公司搭一个基础大数据的 “台子” 至少要请 4 个工程师,即使程序员的月薪降到 12k,也意味着每年至少 50 万元的成本。在创业初期,产品、商业模式都需要不断打磨、改善的情况下,分出精力和财力去做这件事,不一定划算。

所以这种服务交由第三方企业来做是趋势,但由于价格高、服务不容易产品化、标准化,导致不容易区分服务的水平。另外,一家第三方服务商在不同应用场景上也有不同的表现,做得好坏主要还是看应用场景以及是否能结合客户业务来提升其业绩。

最近刚刚拿到来自真格基金、众米资本和掌门科技集团1000 万元天使投资的 “达观数据科技(官网)”,主要的应用有三:数据挖掘分析、搜索性能优化、通过用户画像做精准推荐。同样以智能推荐为核心,较为成熟的国外公司是Taboola。

在数据采集方面,大数据公司通常会用爬虫抓取网络信息,并打通第三方应用 SDK、Java Script 接口来获取一些浅层数据,比如日活、月活、用户留存率等等。而除此之外,达观还要求其客户向其打通更深层的 js 数据,比如用户点击行为、收藏记录、付费记录等等。

在此之后达观为客户提供最基础的服务是数据分析,比如用户在应用搜索栏和个性推荐栏中的转化率分别是多少。该公司也推出了一个免费的 APP “达观公众号”,为微信公众号运营人员提供数据分析工具,希望以此积累数据和用户口碑。

而达观核心的应用场景则是搜索优化和智能推荐,前者如关键字补全、自动纠错、相关搜索、中英文自动串联识别,这些体验我们能在 Google、百度等搜索引擎中感知到,中小企业很难做好却又非常需要,这就是为何知乎要引入搜狗来提供搜素技术(知乎的搜索体验一直饱受诟病)。

智能推荐的应用也不难理解,早期以 Amazon 为典型的商品推荐算法用户早已司空见惯,比如用户在某电商买了辆自行车,随即便推荐坐垫、头盔等相关产品,常见的算法原理有 “与你类似的人喜欢什么” 以及 “从你喜欢的东西推测出你还会喜欢什么”。许多创业公司都是通过为产品打 tag 的方式强行关联相似产品,体验不一定好。

达观在引擎架构研发中使用到了点击模型,通过与用户的隐性交互如点击反馈,可以对结果进行调优:将符合用户偏好但位置靠后的 item 提取至前,或者将不符合用户意图的 item 降权减分。

以电商推荐系统为例,这里引用该公司技术人员江永青在其微信公号发布文章中的论述:

协同过滤算法中,如果没有显性的评分机制,就需要收集点击的行为来作为正向的评分。不同类型的点击(如查看、加购物车、加关注等)可以生成不同维度的二维相似度矩阵,最后推荐的结果由这些矩阵计算生成的中间结果加权得到。

不过江永青也表示点击模型存在一些挑战和难点,包括位置偏向、冷启动数据不足、感知相关性与数据无关、无法覆盖长尾点击数据、故意点击作弊、Session 手机难。

大数据服务的量化标准是为客户带来多少业绩提升,达观数据 COO 冯佳妮向 36 氪列举了一些案例,其中比较突出的是文学网站 “潇湘书院”,该公司根据用户浏览、点击、购买等记录做出一套新的推荐系统,较之前提升了 300%的下单购买率、85%的点击率,年费大概为几十万元。

达观数据自 2015年5月 创建、10月 上线达观公众号产品,至今已累计服务 8000 个自媒体用户。

而其面向大 B 客户的服务则按照 SaaS 的形式收取年费,每笔从 20 万元至 200 万元不等。冯佳妮表示,已经在和一些电商企业洽谈数据打通事宜,比如某国内女性经期管理应用、同仁堂旗下的保健品电商品台,还有一家 FA 机构。该公司也将于今年上半年和复旦大学计算机学院合作组建 “大数据实验室”,与科研机构联合做政企服务,相关政府单位已经提出文化场所选址规划、管辖范围内企业运营情况分析等需求。

做企业深度服务的订单周期较慢是正常现象,但达观面临的主要问题还是如何获得更多客户,不得不解决的问题有两个:

需要提供统一接口,满足普通企业的基础需求,客户提出个性化需求后只需做简单的改动而不用重头再来。冯佳妮表示未来希望做成类似云服务的产品,让客户按需选择服务。

目前达观团队有 20 余名,因人手不够的问题只好将一些找上门来的客户暂时搁置,即使该团队有不少技术大牛,但人才稀缺是不得不考虑的问题。

达观数据成立时间只有 7 个月,核心的三位联合创始人全部出自盛大:

CEO 陈运文为复旦大学计算机博士,曾担任盛大文学首席数据官,腾讯文学高级总监、数据中心负责人,百度核心技术研发工程师,国际计算机学会(ACM)会员,中国计算机学会(CCF)高级会员,在国际顶级学术期刊和会议上发表多篇 SCI 论文,多次参加 ACM 国际数据挖掘竞赛并获得冠军荣誉;

CTO 纪达麒为原腾讯文学数据中心高级研究员、盛大文学技术总监等职务; 原搜狗广告技术部和百度技术部高级工程师;拥有北京邮电大学计算机硕士学位;

COO 冯佳妮为原盛大云计算公司运营总监、安普丹华国际咨询公司高级咨询师,多次获安普丹华公司 Top-Sales 荣 誉;拥有山西财经大学工商管理和商务英语双学士学位。

注:该团队正在招募各类人才,有意者可联系 Hr@datagrand.com

原创文章,作者:暮雨,如若转载,请注明出处:http://36kr.com/p/5042353.html

-

大数据

大数据

神秘大数据公司Palantir融资8.8亿美元,估值高达200亿美元

在这个月中旬的时候,有报道称 Palantir 在新一轮融资中获得1.29 亿美元投资。实际上 Palantir 本轮的融资金额要远远高于这个数字。

根据硅谷大数据公司 Palantir 今天向美国证券交易委员会提交的一份文件显示,公司在新一轮融资中获得 8.8 亿美元的投资。至此,Palantir 的融资总额已达 23.2 亿美元。担任本次融资顾问的摩根士丹利和 SF Sentry Securities。

Palantir 在此轮融资中的估值高达 200 亿美元,成为仅次于 Airbnb、小米和 Uber 的估值第四高的科技初创公司。

作为一家带有神秘色彩的大数据公司,Palantir 的客户目前主要分两类,一类是美国政府和军方客户,包括 CIA、NSA、FBI、海陆空三军、DIA(国防情报局等;一类包含银行、投行等金融机构。除此之外,还包括大健康、医疗、能源等数据方向的客户。

在 Palantir 成立之前,防止犯罪分子曾利用 Paypal 洗钱,Paypal 就开发了一套软件来应对可疑的资金转移,再由分析师对筛选出来的交易一一进行排查。但随着交易量的增加,人力已经不能完成。Paypal 便再次开发了新工具,通过匹配用户过去的交易记录和现在的资金转移情况来查找可疑账户并进行冻结,并因此避免了数千万美元的损失。Palantir 创始人 Peter Thiel 想到,PayPal 的这一防诈骗技术可以为政府提供服务,Palantir 应运而生。

本文参考了信息来源:reuters.com

-

大数据

大数据

寒冬之下,硅谷投资人如何看待企业级市场

美国硅谷一直是科技圈的风向标、领头羊。近年以来,“独角兽(指得到风险投资,估值超过10亿美元的非上市公司)”一词十分活跃,媒体也展开了广泛报道。进入2015年,独角兽也在急剧增加,截止目前全球约有140多家,其中大部分诞生于硅谷。然而独角兽增长的速度远远超过它们退出的能力,同时很多公司如Square等,上市后估值也并不如预期,甚至相差甚远。

对此,长期活跃在美国的清华企业家协会天使基金(TEEC Angel Fund)创始合伙人张于庆判断,美国市场将会在2016年进入估值调整期,“不能说是资本寒冬,但至少会进行估值调整,从而推动产业更健康的发展。”

创业公司面临大公司挑战

尽管大环境将迎来新一阶段的调整,但不同于15年前的互联网震荡,现在这一次的创新大潮中,高科技已渗透进入各个行业,领域广泛,在张于庆看来,实际上还是会产生很多商业机会,前景仍值得期许。

他向记者举例,比如硅谷有一家名为Aromyx的公司可以通过技术积累,将人类的味觉基于生物芯片实现数据化;智能硬件公司Quanergy做出了Google 自驾车上用的激光传感器的下一代产品;初创企业Ginkgo Bioworks利用生物工程技术培养酵母细胞产生食物香料、芳香剂等化学品等。

特别是对于B2B、企业服务市场,得益于更加广阔、稳定增长的市场空间,张于庆表示不仅在美国受到投资界欢迎,在中国同样也是风投重点关注领域。

有数据显示,2014年,中国电子商务B2B市场交易额达8.8万亿元,环比增长23.6%;到2016年,中国电子商务B2B市场交易规模预计达15.2万亿,环比增长32.8%。在O2O热情消散之后,中国2B市场或许迎来新一轮的爆发期。

不过同时张于庆也提醒道,投资人、创业公司在企业级市场将遭遇大公司对垒小公司的挑战,在美国体现为Google等涉入企业市场,在国内则是BAT对企业市场的壮志雄心。“大公司的进入,或将使商业模式的成熟化提前到来,这样小公司可能面临更多挑战。”张于庆表示,好在2B及企业级服务市场空间广阔,能容纳大量的公司成长。

云计算、大数据推动产业发展

从技术角度来看,云计算、大数据、商业分析和智能等平台和工具的发展也在不断地推动、壮大互联网软件产品的产业链发展。

10多年前,一家初创公司需要自己去购买计算机和存储设备;亚马逊云服务的启用让企业用少量资金就可以按月租用设备;虚拟机的出现让企业租用计算设备的一部分计算和存储能力;而容器技术的出现,使得企业可以很容易地部署微服务。

美国知名问答及企业云服务公司Answers COO&CTO,TEEC Angel Fund管理合伙人王金林在接受记者采访时表示,云计算、大数据、商业分析和智能等平台和工具经历了很大的进步,可是依然有非常大的市场空间。无论是对于创业者还是投资者,应该关注未来的技术创新方向,并把握商机。

一是平台和技术向弹性(Elastic)的方向发展,比如在充分使用亚马逊租用的100G存储空间后,无需考虑具体技术细节而轻松实现额外100G空间租用。二是向自动化伸缩(Auto-scaling)发展,避免如租用多台设备,跑完算法后忘记退订单的资金浪费。

“初创公司在弹性和自动化伸缩方面如有建树,则会迎来更多的市场机会。”王金林说道。

随着云存储成本的不断降低,企业拥有越来越多的云端数据,而在拥有了大量数据后,企业开始关注怎样从大数据中洞察商业智能。

“这个领域实际有很多想象和发展空间,如IaaS和数据仓库技术会继续创新;SaaS会继续在不同的垂直领域有所发展;基于数据分析的应用则会越来越广泛的得到应用。”他表示。

投资人的三条选择定律

实际上,在整个宏观环境正在经历转型调整的背景下,可以发现不时有大量资本撤出市场。行业调整所带来的不确定性和焦虑逐渐弥漫开来,一个影响便是机会主义者的减少。张于庆表示,“在创业融资较容易的时候,无论是国外还是国内,产业里会不时出现一些投机主义者,但随着产业步入新的调整期,这类情况在未来一段时间将减少。”

在这样的变革成为“新常态”的同时,另一个更加直接的影响,则是风投公司对创业公司的选择更加谨慎,毕竟一部分投资人被恐惧围绕。然而硬币拥有另一面,仍有一部分投资人继续保持理性,考虑到前文所述的广阔空间,期待发掘另一个独角兽。

在这个眼光决定饭碗的行业,为寻找那些未来的Google,或是BAT,作为投资人的张于庆有着一套判定标准,在他看来这样的标准可能也是众多投资者的通用选择。

他表示,对创业公司的选择判断主要依据三条规则:一是看团队,特别是创始人应该具有饱满的创业热情,同时还有破釜沉舟的事业精神;二是看产品与服务的市场潜力,所以投资人在决策前会进行大量的分析、调查等;三是看技术,创业公司的技术含金量是一个重要评判标准,当然也有一些没有或只有较少技术根基的初创企业,这时则看重其运营能力。

作者 硅星闻

来源:钛媒体

链接:http://www.tmtpost.com/1489493.html

扫一扫 加微信

hrtechchina

扫一扫 加微信

hrtechchina

大数据

大数据

大数据

大数据

大数据

大数据

大数据

大数据

大数据

大数据

大数据

大数据

大数据

大数据

大数据

大数据

大数据

大数据

扫一扫 加微信

hrtechchina

扫一扫 加微信

hrtechchina